Palo Alto Networks AI Security:全面守護 AI 存取與執行安全

在 AI 普及的今天,員工透過瀏覽器或第三方應用程式使用如 ChatGPT、Claude、Gemini、Copilot 等 LLM 服務已是常態,但企業往往無法掌握使用範圍、輸入內容或是否導致機密資料外洩。Palo Alto Networks 的 AI Access Security 解決方案,正是針對這一場景所設計。

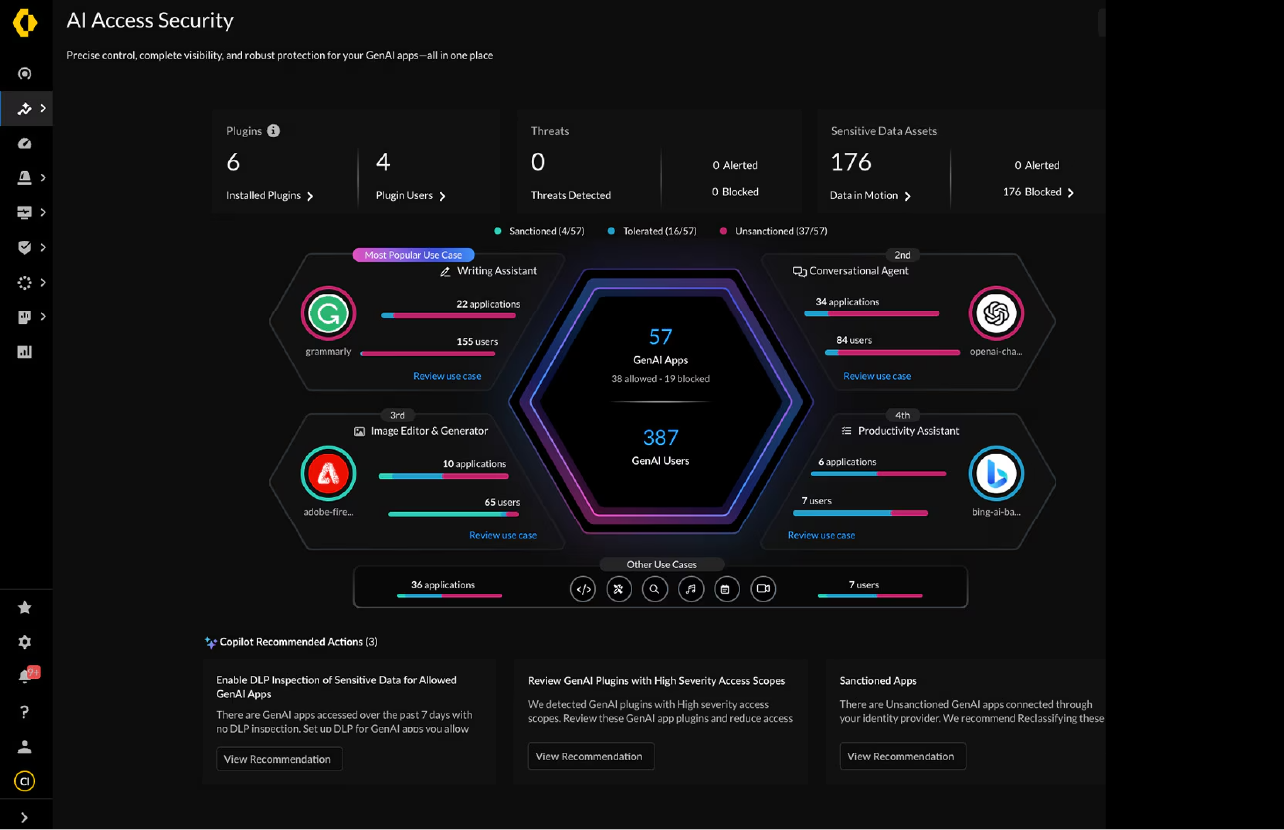

AI Access Security:掌握與控管 GenAI 的使用風險

透過整合 Prisma Access + Enterprise DLP + ADEM(Digital Experience Monitoring),企業可針對所有 GenAI 使用活動進行:

- 即時識別與分類 GenAI 存取行為(區分搜尋、輸入、上傳、下載等類型)

- 控管不同角色對 AI 工具的使用權限(例如只允許開發人員存取特定模型)

- 監控 Prompt 內容,阻擋機敏資料輸入 LLM 系統(含財務數據、客戶資訊、程式碼等)

- 產出使用趨勢報表與風險告警,支援合規性稽核(如 ISO 27001、GDPR)

這項功能可部署於雲端(Prisma Access)、邊界防火牆(NGFW)、或透過 Proxy 模式,涵蓋遠端辦公與多雲架構,讓企業能第一時間掌握誰在用 AI、用來做什麼,以及是否已產生風險行為。

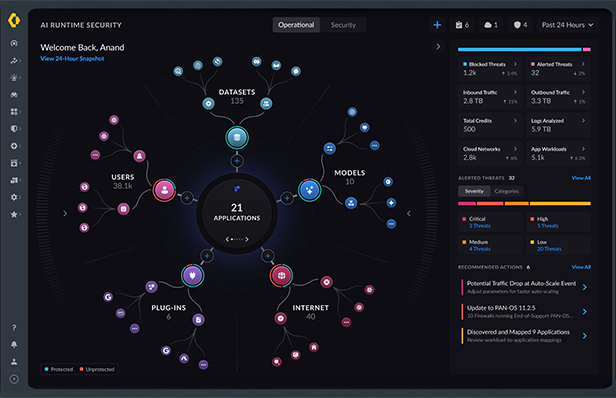

AI Runtime Security:保障自建與第三方 AI 應用的執行安全

除了使用者層的風險控管,許多企業正投入自建 AI 模型、部署 LLM 應用或使用第三方 AI API,以推動業務流程自動化與預測式分析。但這些執行時期的 AI 環境也存在潛在風險:模型可被投毒(Model Poisoning)、Prompt Injection 攻擊、憑證洩漏,甚至遭駭客利用部署 RCE(遠端程式執行)或橫向移動。

Palo Alto Networks 的 Cortex Cloud Security(含 Prisma Cloud 與 Cortex XDR/XSIAM),提供完整的 AI Runtime Security 能力,包括:

- 模型行為監控與異常分析:能針對 LLM 推理行為建立基準值,偵測異常輸入/輸出行為(如不合邏輯的回應或過度查詢)

- Prompt Injection 攻擊偵測與防禦:透過語意分析辨識是否有嘗試繞過原有規則或引導模型產生惡意行為

- API 流量與執行環境掃描:針對部署於雲端容器、Kubernetes 或 serverless 架構的 AI 應用進行風險掃描與修補建議

- IAM 與 Token 管理:強化對 AI 模型 API Token、Key、Service Account 的監控與異常行為告警

- 供應鏈風險管理:追蹤使用的 AI 套件來源、開源模組的 CVE 弱點,防止套件遭後門植入

這些能力由 Cortex XSIAM 整合分析,提供單一視角追蹤從模型初始化、輸入資料、推論過程、API 回應到系統行為的全流程事件鏈,協助 SOC 團隊針對 AI 環境建立精準可視性與主動偵測能力。

整合運用:打造 AI-Native 資安防線

Palo Alto Networks 的 AI Security 解決方案並非多套工具的堆疊,而是以平台化方式將各元件整合於單一資安架構中。企業可透過以下方式達成 AI 安全治理的全方位落實:

- 利用 NGFW、Prisma Access 與 DLP,在存取層即時控管 GenAI 使用風險

- 將所有存取事件與風險告警回饋至 XSIAM,統一追蹤使用者與資產行為

- 在雲端與本地 AI 模型部署處,啟用 Prisma Cloud 與防護 agent,保障執行環境安全

- 整合 Cortex XSOAR,建構針對 AI 資安事件的回應 playbook(如提示注入封鎖、Token 重置、模型下架)

- 將所有 AI 安全事件、風險趨勢與治理指標,輸出報表支援合規與稽核需求

這種跨層級、跨環境的整合設計,不僅符合零信任原則,更是因應 AI 應用規模化所需的安全基礎設施。

在 AI 引領企業數位轉型的新時代,Palo Alto Networks 提供的不只是防護工具,而是一套從設計開始就符合 AI 風險架構的整合式平台。讓您在快速發展 AI 能力的同時,也同樣快步建立對應的資安防線。